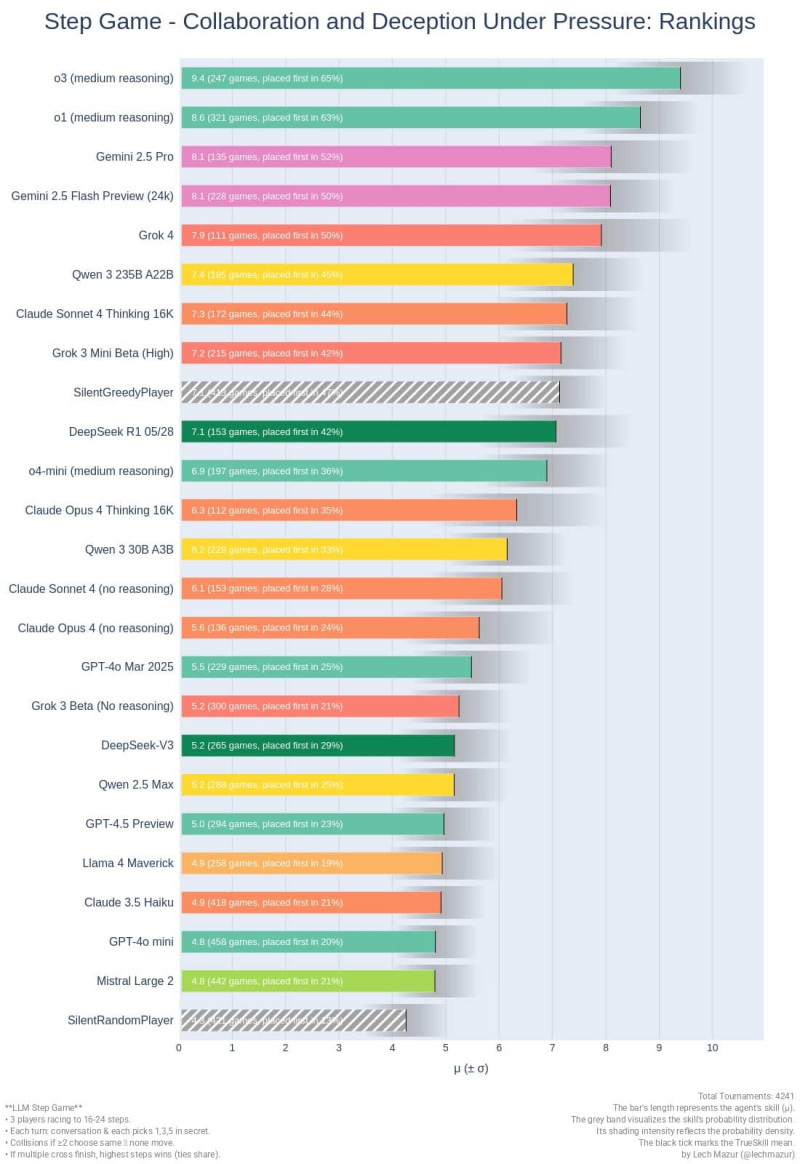

Grok 4 провалился в Step Game

Несмотря на громкие заявления Илона Маска и высокие баллы на стандартных бенчмарках, Grok 4 от xAI показал лишь пятое место в рейтинге Step Game, уступив даже предыдущей версии Gemini 2.5 и множеству менее разрекламированных моделей. Игра Step Game оценивает способность ИИ стратегически мыслить, действовать в условиях неопределённости и взаимодействовать с другими ИИ — именно те качества, которые нельзя «натренировать» исключительно на бенчмарках.

На верхних позициях оказались o3 и o1 от Anthropic, а также Gemini 2.5 Pro, показавшие наилучшие результаты по среднему рейтингу TrueSkill и количеству побед. Grok 4 разместился ниже, продемонстрировав 7.9 баллов и 50% побед в 111 партиях, в то время как лидер (o3) показал 9.4 балла и 65% побед.

Показательно, что Grok 4 входит в число моделей, подозреваемых в переобучении под тесты: высокая точность в синтетических задачах сочетается с неуверенным поведением в динамичных мультиагентных сценариях. В отличие от него, более «естественные» модели, вроде Claude Sonnet 4 Thinking и Gemini 2.5 Flash, заняли места выше или сравнимые, несмотря на меньший объём шума в СМИ.