Pliops представила ускоритель инференса XDP LightningAI — до 8 раз быстрее благодаря SSD вместо HBM

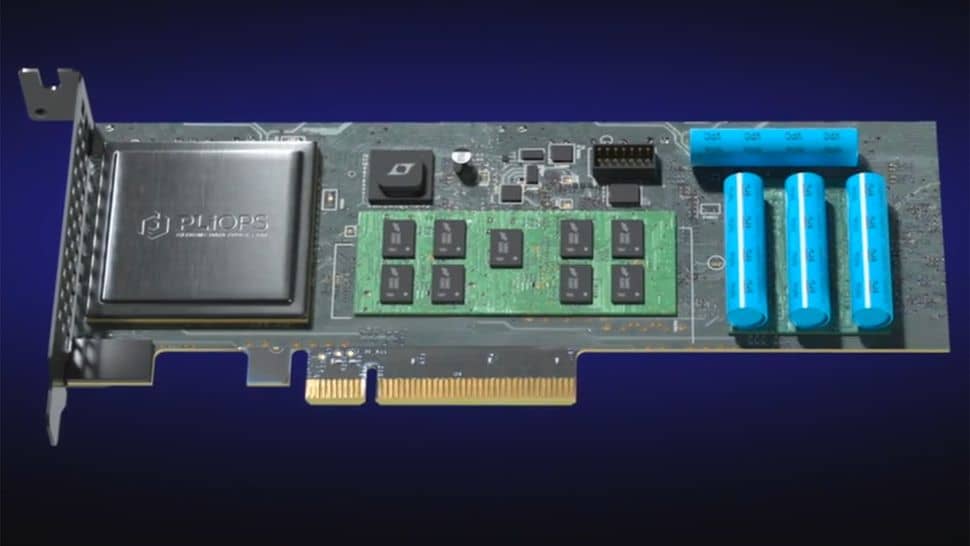

Компания Pliops анонсировала новое решение для ускорения инференса языковых моделей — PCIe-карту XDP LightningAI с программной платформой FusIOnX. Устройство создаёт промежуточный уровень памяти между GPU и SSD, позволяя хранить key-value данные вне HBM и мгновенно возвращать их при необходимости. Это устраняет повторные расчёты и снижает нагрузку на видеокарты, особенно в задачах с длинным контекстом.

В обычных условиях данные, необходимые для поддержки контекста в LLM, хранятся в видеопамяти GPU. Когда объём превышает лимит HBM, старые записи удаляются, и при повторном использовании их нужно пересчитывать. Это приводит к потере производительности. Система от Pliops сохраняет эти данные на высокоскоростных SSD, подключённых через PCIe 5.0, и автоматически управляет их загрузкой в GPU-память.

Карты XDP LightningAI используют специализированный чип XDP ASIC и совместимы с фреймворками vLLM и Nvidia Dynamo. Решение не зависит от конкретного производителя видеокарт и может использоваться как в одиночных, так и в многосерверных конфигурациях. Также поддерживается совместное использование данных между задачами инференса и пользователями.

Компания утверждает, что производительность систем с XDP LightningAI увеличивается в 2.5–8 раз по сравнению с обычной конфигурацией, особенно при работе с длинными запросами. Это позволяет уменьшить требования к количеству видеокарт и снизить общую стоимость владения AI-инфраструктурой. В демонстрации использовалось до 24 SSD с совокупной пропускной способностью 336 ГБ/с.

Устройство уже доступно для интеграции в серверные решения, ориентированные на языковые модели и генеративный ИИ.