AMD расширяет линейку Ryzen 9000 X3D: новые 9950X3D2 и 9850X3D с увеличенным кэшем и TDP

AMD готовит к выпуску два новых процессора с технологией 3D V‑Cache — Ryzen 9 9950X3D2 и Ryzen 7 9850X3D, которые пополнят семейство Ryzen 9000 на архитектуре Zen 5. В отличие от предыдущих моделей, оба чипа получили увеличенный кэш и переработанную конфигурацию теплопакета.

Флагманский Ryzen 9 9950X3D2 построен на 16 ядрах Zen 5, поддерживает до 5.6 ГГц, оснащён 192 МБ L3-кэша за счёт двойного 3D V‑Cache, и имеет TDP 200 Вт — на 30 Вт выше, чем у оригинального 9950X3D. Таким образом, 9950X3D2 предлагает не только больше кэша, но и возможность удерживать более высокую производительность в тяжёлых задачах.

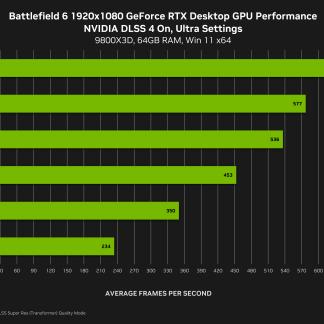

Второй новый чип — Ryzen 7 9850X3D — получил 8 ядер Zen 5, частоту 5.6 ГГц, 96 МБ кэша L3 и TDP 120 Вт. По сравнению с предыдущим 9800X3D, новинка предлагает более высокую частоту и, вероятно, будет занимать промежуточную позицию между игровыми и рабочими системами.

В сравнении с уже представленными процессорами линейки X3D, отличия новинок сводятся к следующим:

— 9950X3D2 выигрывает по кэшу (192 МБ против 128 МБ у 9950X3D) и TDP (200 Вт против 170 Вт), но немного уступает в максимальной частоте (5.6 против 5.7 ГГц);

— 9850X3D превосходит 9800X3D по частоте (5.6 против 5.2 ГГц) при том же объёме кэша и TDP.

На фоне уже выпущенных решений, эти модели выглядят как усиленные версии для тех, кому важны максимальные показатели в играх и рабочих задачах с высокой зависимостью от кэш-памяти. Официальные цены пока не объявлены, но по позиционированию можно ожидать, что 9950X3D2 окажется дороже текущего 9950X3D ($699), а 9850X3D — между 9800X3D ($479) и 9900X3D ($599).

Добавить комментарий