Первый GPU NVIDIA на архитектуре Ampere. Отгрузки DGX A100 начались

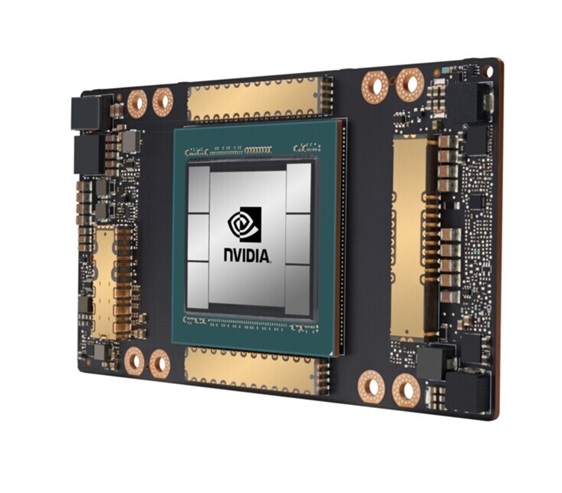

NVIDIA сегодня объявила о начале производства и поставок первого графического процессора на базе архитектуре NVIDIA® Ampere - NVIDIA A100.

Благодаря передовой архитектуре NVIDIA Ampere графический процессор A100 обладает максимальным приростом производительности среди всех восьми поколений GPU NVIDIA и создает единую платформу для обучения ИИ и инференса, ускоряя производительность до 20 раз по сравнению с предшественниками. Универсальный ускоритель A100 также предназначен для задач анализа данных, научных вычислений и облачной графики.

«Стремительное распространение облачных вычислений и ИИ кардинально меняет архитектуру дата-центров: CPU-серверы сегодня уступают место GPU-ускоренным вычислениям, - говорит Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA. - Графические процессоры NVIDIA A100 в 20 раз быстрее в ИИ-задачах и ускоряют машинное обучение на всех этапах – от анализа данных до обучения и инференса. Впервые вертикально и горизонтально масштабируемые задачи можно ускорять на одной платформе. NVIDIA A100 одновременно увеличивает полосу пропускания и снижает стоимость дата-центров».

Новые адаптивные вычислительное технологии в A100 позволяют подобрать необходимую вычислительную мощь для каждой задачи. Каждый GPU A100 может быть разделен на максимум семь независимых инстансов для задач инференса, а благодаря интерконнекту третьего поколения NVIDIA NVLink® графические процессоры A100 можно объединить в один гигантский GPU для работы с моделями большого для работы с масштабными задачами.

Ожидается, что процессоры A100 интегрируют в свои решения следующие поставщики облачных услуг и сборщики систем: Alibaba Cloud, Amazon Web Services (AWS), Atos, Baidu Cloud, Cisco, Dell Technologies, Fujitsu, GIGABYTE, Google Cloud, H3C, Hewlett Packard Enterprise (HPE), Inspur, Lenovo, Microsoft Azure, Oracle, Quanta/QCT, Supermicro и Tencent Cloud.

Широкое применение

Компания Microsoft одной из первых приобрела графические процессоры NVIDIA A100, чтобы задействовать их преимущества в производительности и масштабируемости для задач, связанных с обработкой языка, речи, компьютерного зрения, мультимодальности и не только.

DoorDash, платформа доставки еды по требованию, служащая жизненной артерией для ресторанов во время пандемии, отмечает, что наличие гибкой ИИ-инфраструктуры является важным фактором для возможности масштабировать бизнес, одновременно повышая его эффективность и снижая издержки.

Процессоры A100 также будут использоваться в суперкомпьютерах нового поколения следующих лабораторий и исследовательских организаций: Университета Индианы (США), Юлихского исследовательского центра (Германия), Технологического Института Карлсруэ (Германия), Общества Макса Планка (Max Planck Computing and Data Facility, Германия), Научно-исследовательского вычислительного центра Министерства энергетики США в Национальной лаборатории Лоуренса в Беркли.

Пять инноваций A100

Вычислительные возможности GPU NVIDIA A100 стали возможны благодаря пяти ключевым инновациям:

- Архитектура Ampere — в основе GPU A100 лежит новая архитектура NVIDIA Ampere с более чем 54 млрд транзисторов, что делает его крупнейшим в мире 7-нм процессором.

- Тензорные ядра третьего поколения с TF32 — получившие широкое применение тензорные ядра NVIDIA стали еще более гибкими, быстрыми и простыми в использовании. Теперь они поддерживают TF32 для ИИ, что поднимает скорость ИИ-вычислений до 20 раз для FP32 без каких-либо изменений кода. Также, тензорные ядра теперь поддерживают FP64, что повышает скорость работы в HPC-приложениях до 2.5 раз по сравнению с предыдущим поколением.

- Multi-instance GPU (MIG) позволяет разделить A100 на максимум семь отдельных GPU для выполнения задач разной степени сложности для оптимизации использования GPU и эффективности инвестиций.

- NVIDIA NVLink третьего поколения — удваивает скорость высокоскоростного соединения между GPU для более эффективного масштабирования вычислений.

- Structural sparsity — технология удваивает производительность, используя разреженность данных в задачах ИИ.

Вместе эти возможности превращают NVIDIA A100 в идеальное решение для разнообразных требовательных задач, включая обучение нейросетей и инференс, научное моделирование, диалоговый ИИ, рекомендательные системы, геномику, анализ данных, сейсмическое моделирование и финансовое прогнозирование.

NVIDIA A100 доступен в новых системах, скоро в облаке

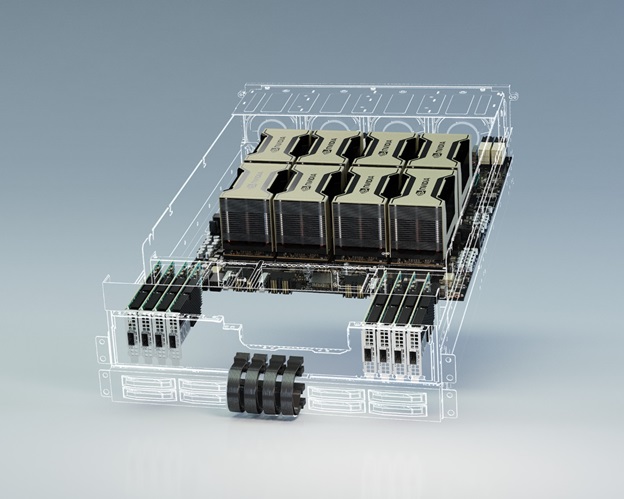

Анонсированная сегодня система NVIDIA DGX A100™ включает восемь GPU NVIDIA A100, связанных интерфейсом NVIDIA NVLink. Система уже доступна у NVIDIA и будет доступна у партнеров компании.

Сервисы на базе A100 планируют предоставлять Alibaba Cloud, AWS, Baidu Cloud, Google Cloud, Microsoft Azure, Oracle и Tencent Cloud.

Ожидается широкая линейка серверов на базе A100 от ведущих производителей, включая Atos, Dell Technologies, Fujitsu, GIGABYTE, H3C, HPE, Inspur, Lenovo, Quanta/QCT и Supermicro.

Чтобы ускорить разработку серверов, NVIDIA создала референсный дизайн модулей HGX A100 в форме интегрируемых плат с различными конфигурациями GPU.

Соединение 4-х GPU в модулях HGX A100 обеспечивает технология NVLink. В модулях же с восьмью GPU взаимодействие GPU-to-GPU происходит через NVIDIA NVSwitch™. Благодаря новой технологии MIG, модуль HGX A100 можно разбить на 56 отдельных GPU, каждый из которых будет быстрее NVIDIA T4. Общая производительность сервера с восьмью GPU на борту в ИИ-вычислениях составляет 10 петафлопс.

Программные оптимизации NVIDIA в A100

NVIDIA также анонсировала несколько обновлений своего программного стека, включая новые версии более чем 50 библиотек CUDA-X, используемых для ускорения графики, моделирования и ИИ; для CUDA 11; для NVIDIA Jarvis, мультимодального фреймворка для диалоговых ИИ-сервисов; для NVIDIA Merlin, фреймворка для рекомендательных систем; и NVIDIA HPC SDK, который включает компиляторы, библиотеки и инструменты, помогающие HPC-разработчикам отлаживать и оптимизировать свой код для A100.

NVIDIA сегодня представила NVIDIA DGX™ A100 – третье поколение самой передовой в мире ИИ-системы с 5 петафлопсами производительности в задачах ИИ, а также мощью и возможностями полноценного дата-центра на одной платформе.

Поставки систем DGX A100 уже начались, и первый заказ отправился в Аргоннскую национальную лабораторию Министерства энергетики США, где возможности ИИ и вычислительная мощь кластера будут направлены на борьбу с COVID-19.

«NVIDIA DGX A100 – это наилучший инструмент для развития ИИ, - говорит Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA. - NVIDIA DGX – это первая ИИ-система, построенная для ускорения машинного обучения на всех этапах – от анализа данных до обучения и инференса. Благодаря огромному приросту производительности в новом поколении DGX, специалисты по машинному обучению могут не бояться стремительного увеличения ИИ-моделей и объема данных.”

Система DGX A100 включает восемь новых графических процессоров NVIDIA A100 с тензорными ядрами, 320 ГБ памяти для обучения самых больших наборов данных и высокоскоростные интерконнекты NVIDIA Mellanox® HDR 200Gbps.

Технология MIG (Multi-Instance GPU) позволяет ускорить процессы, запустив решение небольших задач в параллели за счет разделения DGX A100 на отдельные инстансы, до 56 в системе. Благодаря таким возможностям компании смогут оптимизировать ресурсы и выделять их в соответствии с различными видами нагрузки, включая анализ данных, обучение и инференс на единой программно определяемой платформе.

Широкое применение и поддержка

Ряд крупных компаний, поставщиков услуг и правительственных учреждений уже разместили заказы на системы DGX A100. Первые системы DGX нового поколения отправлены в Аргоннскую национальную лабораторию для борьбы с COVID-19.

Университет Флориды станет первым высшим учебным заведением в США, который получит системы DGX A100, чтобы внедрить возможности ИИ в свой учебный процесс.

Первыми пользователями систем DGX A100 также стали Центр биомедицинского ИИ в Гамбурге, Университет Чулалонгкорна в Таиланде, Немецкий исследовательский центр ИИ, разработчик решений и услуг на базе ИИ Element AI из Монреаля, сиднейская медицинская компания Harrison.ai, компания Artificial Intelligence Office (ОАЭ), ведущая вьетнамская исследовательская лаборатория VinAI Research.

Во всем мире множество общественных и частных организаций успешно применяют тысячи DGX систем предыдущих поколений. Среди них и ведущие автопроизводители, поставщики медицинских услуг, ритейлеры, финансовые институты и логистические компании, способствующие распространению ИИ в своих областях.

NVIDIA создает 700-петафлопсный кластер DGX SuperPOD

NVIDIA также представила новое поколение DGX SuperPOD – кластера, созданного из 140 систем DGX A100, способного обеспечить 700 петафлопс в задачах ИИ. Объединив 140 систем DGX A100 с помощью интерконнета NVIDIA Mellanox HDR 200Gbps InfiniBand, NVIDIA создает собственный суперкомпьютер DGX SuperPOD AI для внутренних исследований в таких областях, как диалоговый ИИ, геномика и автономное вождение.

Новый кластер является одним из самых мощных суперкомпьютеров мира для работы с ИИ и обладает производительностью, которую раньше могли обеспечить только тысячи серверов. Продуманная архитектура корпоративного уровня и производительность DGX A100 позволили NVIDIA построить систему всего за месяц. Раньше на разработку специальных компонентов с подобными суперкомпьютерными возможностями ушли бы годы.

Чтобы помочь клиентам быстрее создавать собственные дата-центры на базе графических процессоров A100, NVIDIA также представила референсную архитектуру DGX SuperPOD, в которой описываются принципы проектирования, используемые при создании супервычислительных кластеров на базе DGX A100.

Программы DGXpert и DGX-Ready Software

NVIDIA также представила две программы: NVIDIA DGXpert, которая позволит ИИ-экспертам оказывать помощь заказчикам DGX-систем, и NVIDIA DGX-Ready Software, которая откроет клиентам преимущества сертифицированного корпоративного программного обеспечения для ИИ-задач.

В рамках первой программы DGX-эксперты смогут помогать клиентам разворачивать современные ИИ-инфраструктуры и непрерывно оптимизировать их.

Программа NVIDIA DGX-Ready Software позволит клиентам быстро определять и запускать протестированные NVIDIA сторонние MLOps-приложения, чтобы повысить продуктивность исследований, ускорить решение задач ИИ и улучшить доступность и использование ИИ-инфраструктуры. Первыми партнерами, получившими сертификацию NVIDIA, стали Allegro AI, cnvrg.io, Core Scientific, Domino Data Lab, Iguazio и Paperspace.

Спецификации DGX A100

- Восемь GPU NVIDIA A100 с тензорными ядрами, с производительность в 5 петафлопс в задачах ИИ, с 320ГБ памяти и полосой пропускания в 12.4 ТБ/с.

- Шесть интерфейсов NVIDIA NVSwitch™ с технологией NVIDIA NVLink® 3-го поколения с двунаправленной полосой пропускания в 4.8 ТБ/с.

- Девять интерфейсов NVIDIA Mellanox ConnectX-6 HDR 200 Гб/с с суммарной двунаправленной полосой пропускания в 3.6 ТБ/с.

- Технологии внутрисетевых вычислений и ускорений, такие, как RDMA, GPUDirect®, Scalable Hierarchical Aggregation и Reduction Protocol (SHARP)™, обеспечивают максимальную производительность и масштабируемость.

- Программный стэк NVIDIA DGX, который включает оптимизированное ПО для ИИ и анализа данных, позволяет компаниям быстрее вернуть инвестиции в ИИ-инфраструктуру.

Одна стойка из пяти систем DGX A100 заменяет дата-центр для обучения нейросетей и инференса, с энергопотреблением в 20 раз меньше, размерами в 25 раз меньше и стоимостью в 10 раз ниже.

Доступность

Системы NVIDIA DGX A100 уже доступны для заказа по цене от 199 000 долларов через NVIDIA Partner Network. Поставщики систем хранения DDN Storage, Dell Technologies, IBM, NetApp, Pure Storage и Vast панируют интегрировать DGX A100 в свой ассортимент, включая решения на базе референсных архитектур NVIDIA DGX POD и DGX SuperPOD.

Партнеры NVIDIA по программе DGX-Ready предлагают услуги по размещению серверов в 122 локациях в 26 странах, чтобы обеспечить экономическую эффективность при размещении DGX инфраструктур. Клиенты смогут размещать и использовать свои инфраструктуры DGX A100 в проверенных дата-центрах мирового класса.

Подробнее смотрите на странице www.nvidia.com/DGXA100.