Чипы NVIDIA Blackwell обеспечили максимальную прибыльность в AI-сегменте, оставив конкурентов позади

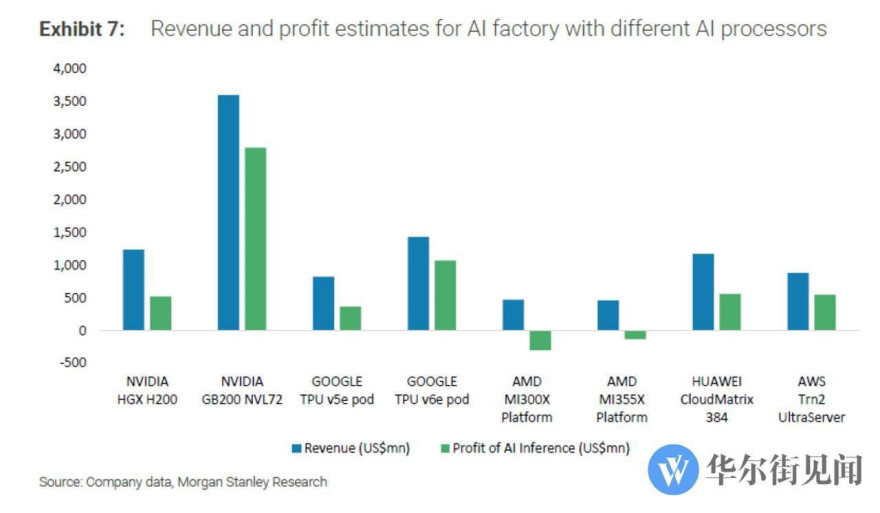

Согласно свежему отчёту Morgan Stanley Research, использование NVIDIA GB200 NVL72 (Blackwell) демонстрирует наилучшие показатели в задачах AI-инференса, обеспечивая до 77,6% прибыли при доходе около 3,5 миллиарда долларов. Это делает платформу лидером среди всех протестированных решений для AI-фабрик мощностью 100 МВт, в которых использовались чипы от NVIDIA, Google, AMD, Huawei и AWS.

Секрет успеха NVIDIA — в полной интеграции аппаратного и программного стека, включая продвинутые CUDA-оптимизации и поддержку FP4-вычислений. Это позволяет значительно снизить издержки и повысить эффективность даже при высоком TCO (общей стоимости владения), сравнимом с AMD MI300X.

Google TPU v6e занял второе место с прибылью 74,9%, а AWS Trn2 UltraServer на третьем с 62,5%. В то же время AMD сталкивается с убытками: платформа MI300X уходит в минус на 64%, а более новая MI355X — на 28,2%. Это связано с тем, что при сопоставимых инвестициях (около $744 млн у AMD и $800 млн у NVIDIA), уровень оптимизации у AMD всё ещё значительно ниже.

По показателю выручки в час чип NVIDIA GB200 приносит $7,5, тогда как у AMD MI355X — только $1,7. Остальные решения — от Google, Huawei и AWS — приносят от $0,5 до $2,0 в час. Таким образом, NVIDIA остаётся вне конкуренции, особенно в условиях, где инференс занимает до 85% AI-рынка.

Ожидается, что NVIDIA в этом году представит Blackwell Ultra с приростом производительности на 50%, а в 2026 году — архитектуру Rubin. AMD также готовит MI400, но пока NVIDIA сохраняет заметное преимущество в AI-сегменте.