Micron начала поставки HBM4 — до 2 ТБ/с на стек и на 60% выше производительность, чем у HBM3E

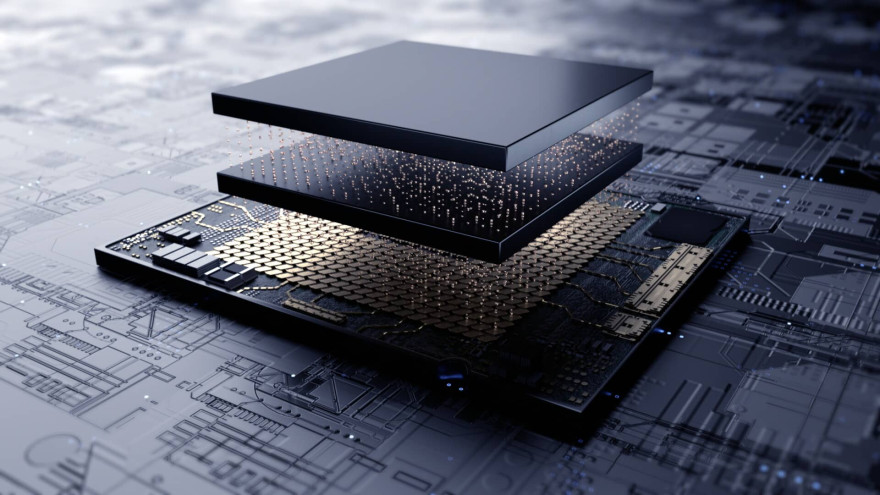

Micron официально начала поставки памяти нового поколения HBM4 ключевым клиентам, занимающимся разработкой платформ для искусственного интеллекта. Новые 36-гигабайтные стеки в 12-слойной компоновке демонстрируют серьёзный прирост в пропускной способности и энергоэффективности, что особенно актуально для центров обработки данных и масштабных AI-систем.

Разработанная на базе техпроцесса 1β (1-beta) DRAM, HBM4 обеспечивает более 2,0 ТБ/с пропускной способности на стек благодаря 2048-битному интерфейсу. Это на более чем 60% выше, чем у предыдущего поколения HBM3E. Такой скачок позволяет эффективно обрабатывать задачи, связанные с обучением и инференсом больших языковых моделей, а также поддерживать работу ИИ-ускорителей в критически нагруженных секторах.

Micron также заявила об улучшении энергоэффективности на более чем 20%, что позволяет снижать общее энергопотребление в дата-центрах при сохранении высокой плотности вычислений. В компании подчеркивают, что выпуск HBM4 строго синхронизирован с графиками готовности заказчиков, включая разработчиков передовых AI-платформ. В их числе уже названы NVIDIA Vera Rubin и AMD Instinct MI400, где новая память будет применяться.

Micron сообщает, что продукция уже поставляется клиентам и активно тестируется, а первые полноценные поставки начнутся по мере масштабирования производства. Это очередной шаг к укреплению позиций компании на рынке памяти для искусственного интеллекта. HBM4 станет ключевым компонентом будущих ИИ-ускорителей, особенно в сегментах медицины, финансов и транспорта, где критична как скорость, так и энергоэффективность.